Puntos de control

Disable and re-enable the Dataflow API

/ 20

Create a BigQuery Dataset (name: taxirides)

/ 20

Create a table in BigQuery Dataset

/ 20

Create a Cloud Storage bucket

/ 20

Run the Pipeline

/ 20

Dataflow: Qwik Start - Plantillas

- GSP192

- Descripción general

- Configuración

- Tarea 1. Crea un conjunto de datos y una tabla de Cloud BigQuery con Cloud Shell

- Tarea 2. Crea una tabla y un conjunto de datos de Cloud BigQuery con la consola de Cloud

- Tarea 3: Ejecuta la canalización

- Tarea 4. Envía una consulta

- Tarea 5. Pon a prueba tus conocimientos

- ¡Felicitaciones!

GSP192

Descripción general

En este lab, aprenderás a crear una canalización de transmisión con una de las plantillas de Google Cloud Dataflow. En especial, usarás la plantilla Cloud Pub/Sub to BigQuery, que lee mensajes escritos en JSON de un tema Pub/Sub y los envía a una tabla de BigQuery. Puedes encontrar la documentación para esta plantilla en la guía Comienza con las plantillas proporcionadas por Google.

Podrás elegir entre usar la línea de comandos de Cloud Shell o la consola de Cloud para crear el conjunto de datos y la tabla de BigQuery. Elige un método para usar, luego continúa con ese método el resto del lab. Si quieres probar ambos métodos, realiza este lab por segunda vez.

Configuración

Antes de hacer clic en el botón Comenzar lab

Lee estas instrucciones. Los labs son cronometrados y no se pueden pausar. El cronómetro, que comienza a funcionar cuando haces clic en Comenzar lab, indica por cuánto tiempo tendrás a tu disposición los recursos de Google Cloud.

Este lab práctico te permitirá realizar las actividades correspondientes en un entorno de nube real, no en uno de simulación o demostración. Para ello, se te proporcionan credenciales temporales nuevas que utilizarás para acceder a Google Cloud durante todo el lab.

Para completar este lab, necesitarás lo siguiente:

- Acceso a un navegador de Internet estándar (se recomienda el navegador Chrome)

- Tiempo para completar el lab: Recuerda que, una vez que comienzas un lab, no puedes pausarlo.

Cómo iniciar su lab y acceder a la consola de Google Cloud

-

Haga clic en el botón Comenzar lab. Si debe pagar por el lab, se abrirá una ventana emergente para que seleccione su forma de pago. A la izquierda, se encuentra el panel Detalles del lab que tiene estos elementos:

- El botón Abrir la consola de Google

- Tiempo restante

- Las credenciales temporales que debe usar para el lab

- Otra información para completar el lab, si es necesaria

-

Haga clic en Abrir la consola de Google. El lab inicia recursos y abre otra pestaña en la que se muestra la página de acceso.

Sugerencia: Ordene las pestañas en ventanas separadas, una junto a la otra.

Nota: Si ve el diálogo Elegir una cuenta, haga clic en Usar otra cuenta. -

Si es necesario, copie el nombre de usuario del panel Detalles del lab y péguelo en el cuadro de diálogo Acceder. Haga clic en Siguiente.

-

Copie la contraseña del panel Detalles del lab y péguela en el cuadro de diálogo de bienvenida. Haga clic en Siguiente.

Importante: Debe usar las credenciales del panel de la izquierda. No use sus credenciales de Google Cloud Skills Boost. Nota: Usar su propia Cuenta de Google podría generar cargos adicionales. -

Haga clic para avanzar por las páginas siguientes:

- Acepte los términos y condiciones.

- No agregue opciones de recuperación o autenticación de dos factores (esta es una cuenta temporal).

- No se registre para obtener pruebas gratuitas.

Después de un momento, se abrirá la consola de Cloud en esta pestaña.

Activa Cloud Shell

Cloud Shell es una máquina virtual que cuenta con herramientas para desarrolladores. Ofrece un directorio principal persistente de 5 GB y se ejecuta en Google Cloud. Cloud Shell proporciona acceso de línea de comandos a tus recursos de Google Cloud.

- Haz clic en Activar Cloud Shell

en la parte superior de la consola de Google Cloud.

Cuando te conectes, habrás completado la autenticación, y el proyecto estará configurado con tu PROJECT_ID. El resultado contiene una línea que declara el PROJECT_ID para esta sesión:

gcloud es la herramienta de línea de comandos de Google Cloud. Viene preinstalada en Cloud Shell y es compatible con la función de autocompletado con tabulador.

- Puedes solicitar el nombre de la cuenta activa con este comando (opcional):

-

Haz clic en Autorizar.

-

Ahora, el resultado debería verse de la siguiente manera:

Resultado:

- Puedes solicitar el ID del proyecto con este comando (opcional):

Resultado:

Resultado de ejemplo:

gcloud, consulta la guía con la descripción general de gcloud CLI en Google Cloud.

Asegúrate de que la API de Dataflow se haya vuelto a habilitar de forma correcta

Para garantizar el acceso a la API necesaria, reinicia la conexión a la API de Dataflow.

-

En la consola de Cloud, escribe “API de Dataflow” en la barra de búsqueda superior. Haz clic en el resultado de API de Dataflow.

-

Haz clic en Administrar.

-

Haz clic en Inhabilitar API.

Si se te solicita confirmar, haz clic en Inhabilitar.

- Haz clic en Habilitar.

Cuando se haya habilitado de nuevo la API, se mostrará en la página la opción para inhabilitarla.

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada.

Tarea 1. Crea un conjunto de datos y una tabla de Cloud BigQuery con Cloud Shell

Primero, crearemos un conjunto de datos y una tabla de BigQuery.

bq. Omite este paso si deseas ejecutar este lab en la consola.

- Ejecuta el comando siguiente para crear un conjunto de datos llamado

taxirides:

El resultado debería ser similar a este:

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si creaste un conjunto de datos de BigQuery con éxito, verás una puntuación de evaluación.

Ahora que creaste el conjunto de datos, lo usarás en el paso siguiente para crear una instancia de una tabla de BigQuery.

- Para ello, ejecuta el comando siguiente:

El resultado debería ser similar a este:

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si creaste con éxito una tabla en el conjunto de datos de BigQuery, verás una puntuación de evaluación.

A primera vista, el comando bq mk parece un poco complicado. Sin embargo, con un poco de ayuda de la documentación sobre la línea de comandos de BigQuery, podemos descifrar qué sucede aquí. Por ejemplo, en la documentación se brinda más información sobre el esquema:

- Ya sea la ruta de acceso a un archivo de esquema JSON local o una lista separada por comas de definiciones de columnas con el formato siguiente:

[FIELD]:[DATA_TYPE],[FIELD]:[DATA_TYPE].

En este caso, estamos usando la última opción, una lista separada por comas.

Crea un bucket de Cloud Storage

Ahora que ya creamos las instancias de la tabla, vamos a crear un bucket.

Usa el ID del proyecto como nombre del bucket para asegurarte de usar un nombre único a nivel global:

- Para ello, ejecuta comandos siguientes:

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si creaste con éxito un bucket de Cloud Storage, verás una puntuación de evaluación.

Una vez que hayas creado el bucket, desplázate hacia abajo hasta la sección Run the Pipeline.

Tarea 2. Crea una tabla y un conjunto de datos de Cloud BigQuery con la consola de Cloud

-

En el menú de la izquierda, en la sección Macrodatos, haz clic en BigQuery.

-

Luego, haz clic en Listo.

-

Haz clic en los tres puntos junto al nombre de tu proyecto en la sección Explorador y, luego, en Crear conjunto de datos.

-

Ingresa

taxiridescomo el ID de tu conjunto de datos: -

Selecciona us (varias regiones de Estados Unidos) en Ubicación de los datos.

-

Conserva los demás parámetros de configuración predeterminados y haz clic en CREAR CONJUNTO DE DATOS.

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si creaste un conjunto de datos de BigQuery con éxito, verás una puntuación de evaluación.

-

Ahora deberías ver el conjunto de datos

taxiridesdebajo del ID de tu proyecto en la sección izquierda de la consola. -

Haz clic en los tres puntos junto al conjunto de datos

taxiridesy elige Abrir. -

Luego, elige CREAR TABLA en la sección derecha de la consola.

-

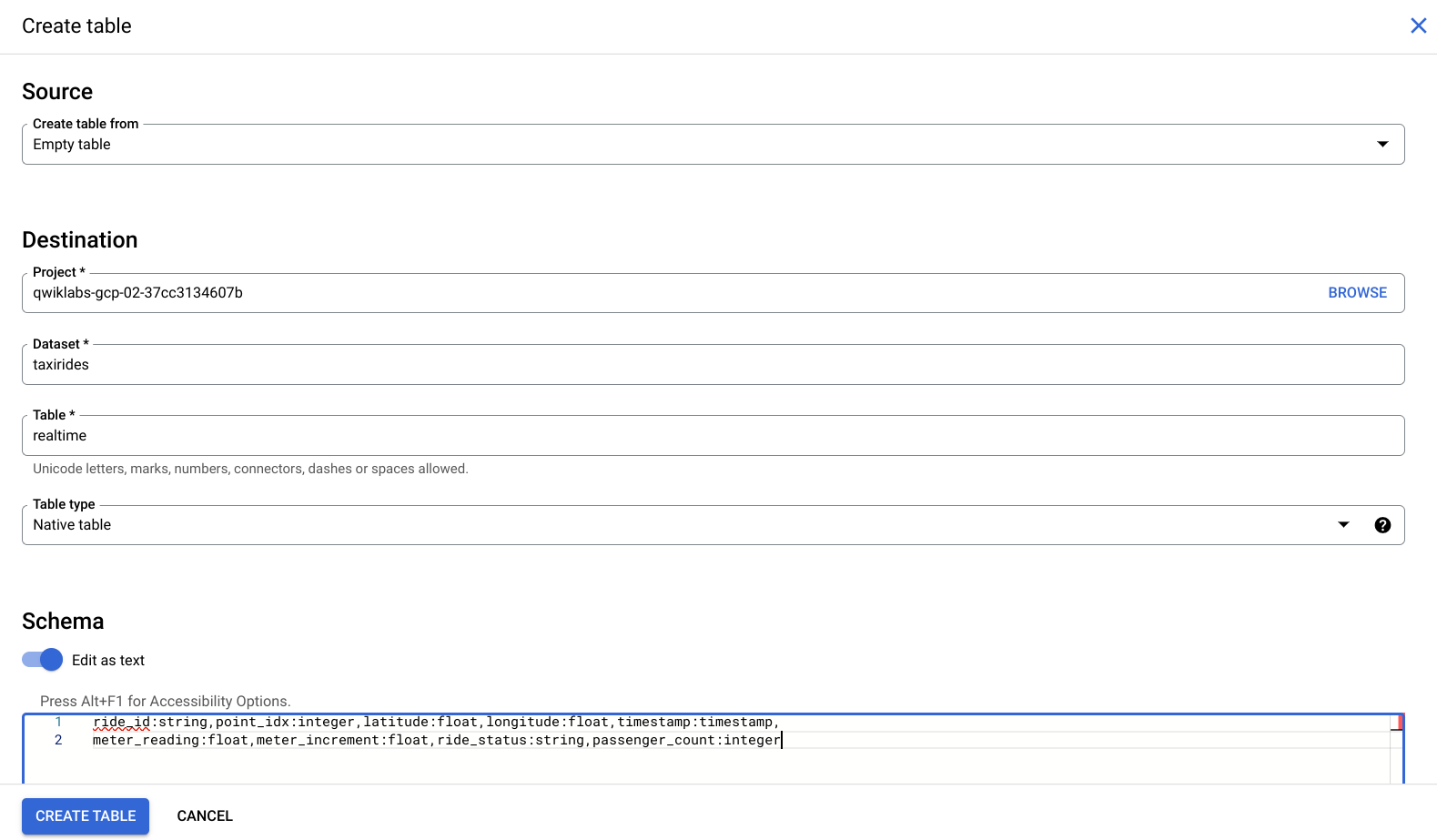

En la entrada Destino > Nombre de la tabla, escribe

realtime. -

En Esquema, activa el control deslizante Editar como texto y, luego, escribe lo siguiente:

La consola debería verse como se muestra a continuación:

- Ahora haz clic en Crear tabla.

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si creaste con éxito una tabla en el conjunto de datos de BigQuery, verás una puntuación de evaluación.

Crea un bucket de Cloud Storage

-

Regresa a la consola de Cloud y navega a Cloud Storage > Buckets > Crear bucket.

-

Usa el ID del proyecto como nombre del bucket para asegurarte de usar un nombre único a nivel global:

-

Deja el resto de los parámetros de configuración como predeterminados y haz clic en Crear.

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si creaste con éxito un bucket de Cloud Storage, verás una puntuación de evaluación.

Tarea 3: Ejecuta la canalización

Implementa la plantilla de Dataflow:

En la consola de Google Cloud, en el menú de navegación, haz clic en Dataflow > Trabajos para ver tu trabajo de Dataflow.

Consulta el documento para obtener más información.

Prueba la tarea completada

Haz clic en Revisar mi progreso para verificar la tarea realizada. Si ejecutaste con éxito la canalización de Dataflow, verás una puntuación de evaluación.

Verás cómo se compilan tus recursos y se preparan para su uso.

Para ver los datos escritos en BigQuery, haz clic en BigQuery en Menú de navegación.

- Cuando se abra la IU de BigQuery, verás que se agregó el conjunto de datos taxirides en el nombre de tu proyecto, además de la tabla realtime debajo.

Tarea 4. Envía una consulta

Puedes enviar consultas con SQL estándar.

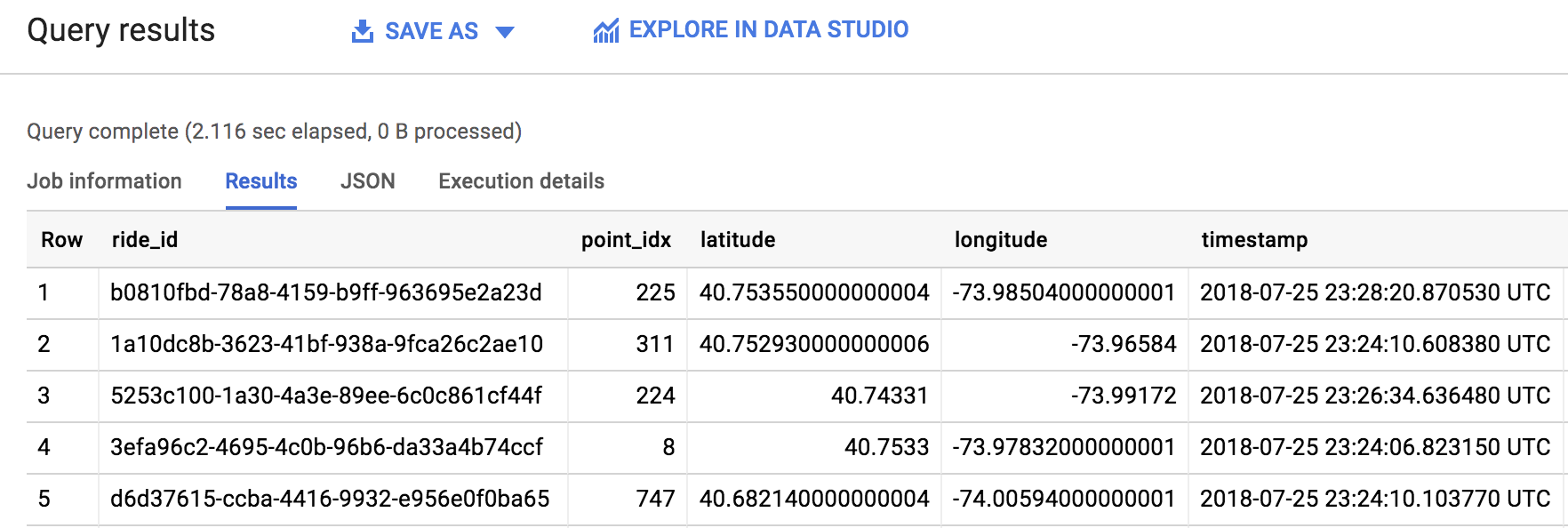

- En el editor de BigQuery, agrega lo siguiente para consultar los datos de tu proyecto:

- Ahora, haz clic en EJECUTAR.

Si surge algún problema o error, ejecuta de nuevo la consulta (la canalización puede tardar un minuto en iniciarse).

- Una vez ejecutada con éxito la consulta, verás el resultado en el panel Resultados de la consulta, como se muestra a continuación:

¡Muy bien! Extrajiste 1,000 viajes en taxi de un tema Pub/Sub y los enviaste a una tabla de BigQuery. Como viste de primera mano, las plantillas son una forma práctica y sencilla de ejecutar trabajos de Dataflow. En la documentación de Dataflow, asegúrate de consultar otras plantillas de Google en la guía Comienza con las plantillas proporcionadas por Google.

Tarea 5. Pon a prueba tus conocimientos

A continuación, se presentan algunas preguntas de opción múltiple para reforzar tus conocimientos sobre los conceptos de este lab. Intenta responderlas lo mejor posible.

¡Felicitaciones!

Finaliza tu Quest

Este lab de autoaprendizaje forma parte de la Quest Baseline: Data, ML, AI. Una Quest es una serie de labs relacionados que forman una ruta de aprendizaje. Si completas esta Quest, obtendrás una insignia como reconocimiento por tu logro. Puedes hacer públicas tus insignias y agregar vínculos a ellas en tu currículum en línea o en tus cuentas de redes sociales. Inscríbete en esta Quest o en cualquiera que contenga este lab y obtén un crédito inmediato de finalización. Consulta el catálogo de Google Cloud Skills Boost para ver todas las Quests disponibles.

Próximos pasos/Más información

Este lab forma parte de una serie llamada Qwik Starts. Estos labs están diseñados para ofrecerte una visión general de las numerosas funciones disponibles de Google Cloud. Busca “Qwik Starts” en el catálogo de Google Cloud Skills Boost para elegir el lab siguiente que desees completar.

Capacitación y certificación de Google Cloud

Recibe la formación que necesitas para aprovechar al máximo las tecnologías de Google Cloud. Nuestras clases incluyen habilidades técnicas y recomendaciones para ayudarte a avanzar rápidamente y a seguir aprendiendo. Para que puedas realizar nuestros cursos cuando más te convenga, ofrecemos distintos tipos de capacitación de nivel básico a avanzado: a pedido, presenciales y virtuales. Las certificaciones te ayudan a validar y demostrar tus habilidades y tu conocimiento técnico respecto a las tecnologías de Google Cloud.

Actualización más reciente del manual: 10 de noviembre de 2023

Prueba más reciente del lab: 10 de noviembre de 2023

Copyright 2024 Google LLC. All rights reserved. Google y el logotipo de Google son marcas de Google LLC. Los demás nombres de productos y empresas pueden ser marcas de las respectivas empresas a las que estén asociados.