Points de contrôle

Run Cloud Dataprep jobs to BigQuery

/ 100

Créer un pipeline de transformation de données avec Cloud Dataprep

- GSP430

- Présentation

- Préparation

- Tâche 1 : Ouvrir Google Cloud Dataprep

- Tâche 2 : Créer un ensemble de données BigQuery

- Tâche 3 : Connecter des données BigQuery à Cloud Dataprep

- Tâche 4 : Explorer les champs de données de l'ensemble "ecommerce" dans l'UI

- Tâche 5 : Nettoyer les données

- Tâche 6 : Enrichir les données

- Tâche 7 : Exécuter des jobs Cloud Dataprep dans BigQuery

- Félicitations !

Nous avons développé cet atelier avec notre partenaire Alteryx. Vos informations personnelles pourront être partagées avec Alteryx, le collaborateur d'atelier, si vous avez accepté de recevoir des actualités sur les produits, des annonces et des offres sur la page de profil de votre compte.

GSP430

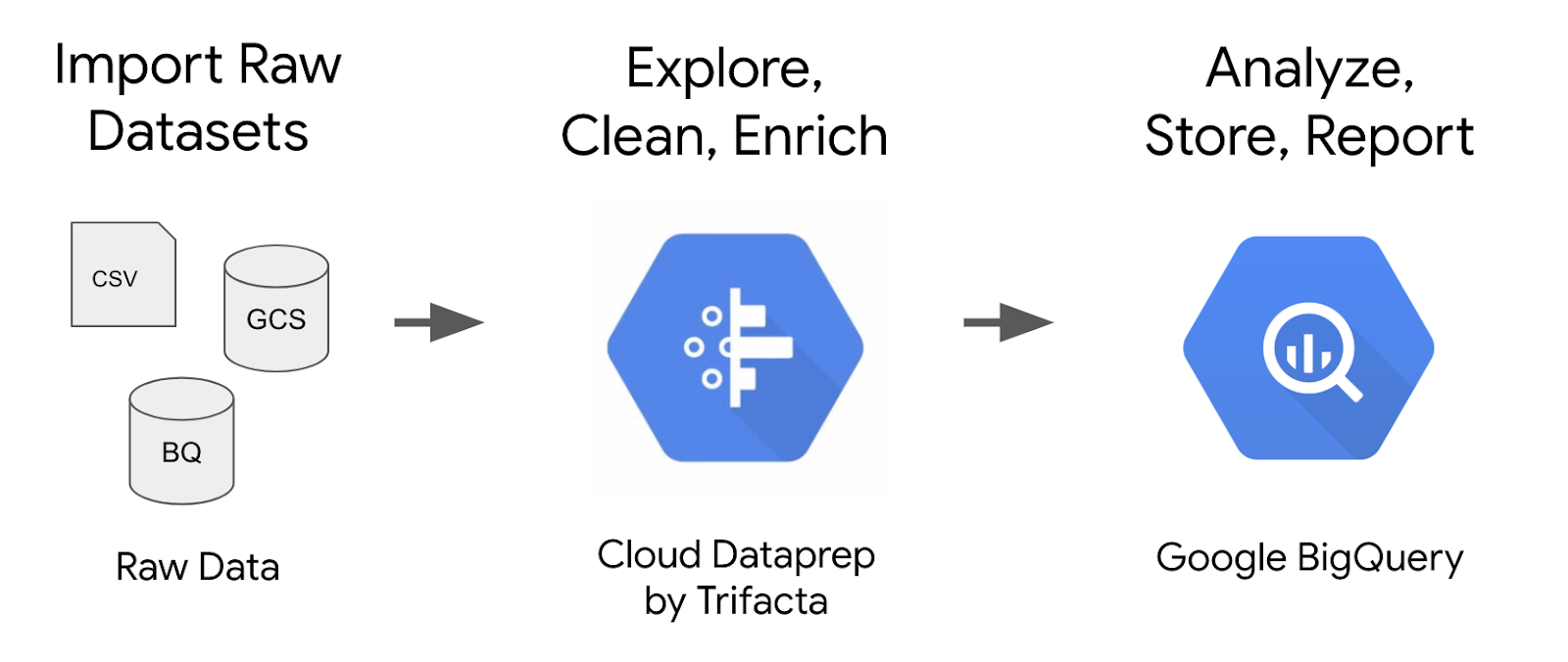

Présentation

Cloud Dataprep by Alteryx est un service intelligent qui permet d'explorer visuellement, de nettoyer et de préparer des données structurées ou non structurées à des fins d'analyse. Dans cet atelier, vous allez utiliser l'interface utilisateur de Cloud Dataprep afin de créer un pipeline de transformation de données qui génère des résultats dans BigQuery.

Vous exploiterez un ensemble de données d'e-commerce comptant des millions d'enregistrements Google Analytics pour le Google Merchandise Store, chargé dans BigQuery. Vous disposez d'une copie de cet ensemble de données pour cet atelier, et vous allez explorer les champs et lignes qu'il contient afin d'obtenir des informations.

Objectifs

Dans cet atelier, vous apprendrez à effectuer les opérations suivantes :

- Connecter des ensembles de données BigQuery à Cloud Dataprep

- Découvrir la qualité des ensembles de données avec Cloud Dataprep

- Créer un pipeline de transformation de données avec Cloud Dataprep

- Exécuter les sorties des jobs de transformation dans BigQuery

Préparation

Nous vous recommandons de suivre l'atelier Utiliser Cloud Dataprep sur Google Cloud avant celui-ci.

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement. Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google. L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte. -

Si nécessaire, copiez le nom d'utilisateur inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue Se connecter. Cliquez sur Suivant.

-

Copiez le mot de passe inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue de bienvenue. Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis dans le panneau de gauche. Ne saisissez pas vos identifiants Google Cloud Skills Boost. Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés. -

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas aux essais offerts.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Tâche 1 : Ouvrir Google Cloud Dataprep

-

Dans la console Cloud, accédez au menu de navigation, puis sous Analyse, sélectionnez Dataprep.

-

Avant d'accéder à Cloud Dataprep, prenez connaissance des conditions d'utilisation de Google Cloud Dataprep, puis cliquez sur Accept (Accepter).

-

Cochez la case et cliquez sur Agree and Continue (Accepter et continuer) lorsque vous êtes invité à partager les informations de votre compte avec Alteryx.

-

Cliquez sur Allow (Autoriser) pour autoriser Alteryx à accéder à votre projet.

-

Sélectionnez vos identifiants Qwiklabs pour vous connecter, puis cliquez sur Allow (Autoriser).

-

Cochez la case et cliquez sur Accept (Accepter) pour accepter les conditions d'utilisation d'Alteryx.

-

Si vous êtes invité à utiliser l'emplacement par défaut pour le bucket de stockage, cliquez sur Continue (Continuer).

Tâche 2 : Créer un ensemble de données BigQuery

Bien que cet atelier se concentre principalement sur Cloud Dataprep, vous devez utiliser BigQuery comme point de terminaison pour l'ingestion de l'ensemble de données dans le pipeline et comme destination du résultat une fois le pipeline terminé.

-

Dans la console Cloud, accédez au menu de navigation, puis cliquez sur BigQuery.

-

Le message Bienvenue sur BigQuery dans Cloud Console s'affiche. Il contient un lien vers le guide de démarrage rapide et liste les mises à jour de l'interface utilisateur.

-

Cliquez sur OK.

-

Dans le volet Explorateur, sélectionnez le nom de votre projet :

- Dans le volet de gauche, sous Explorateur, cliquez sur l'icône Afficher les actions (

) à droite de l'ID de votre projet, puis sur Créer un ensemble de données.

- Dans le champ ID de l'ensemble de données, saisissez

ecommerce. - Conservez les valeurs par défaut dans les autres champs.

-

Cliquez sur CRÉER UN ENSEMBLE DE DONNÉES. Votre ensemble de données s'affiche maintenant sous votre projet dans le volet de gauche.

-

Copiez la requête SQL suivante, puis collez-la dans l'éditeur de requête :

-

Cliquez sur EXÉCUTER. Cette requête copie un sous-ensemble de l'ensemble de données d'e-commerce brut public (données d'une journée de session, soit environ 56 000 enregistrements) dans une nouvelle table nommée

all_sessions_raw_dataprep, qui a été ajoutée à votre ensemble de données d'e-commerce pour que vous puissiez l'explorer et la nettoyer dans Cloud Dataprep. -

Vérifiez que la nouvelle table existe dans votre ensemble de données

ecommerce:

Tâche 3 : Connecter des données BigQuery à Cloud Dataprep

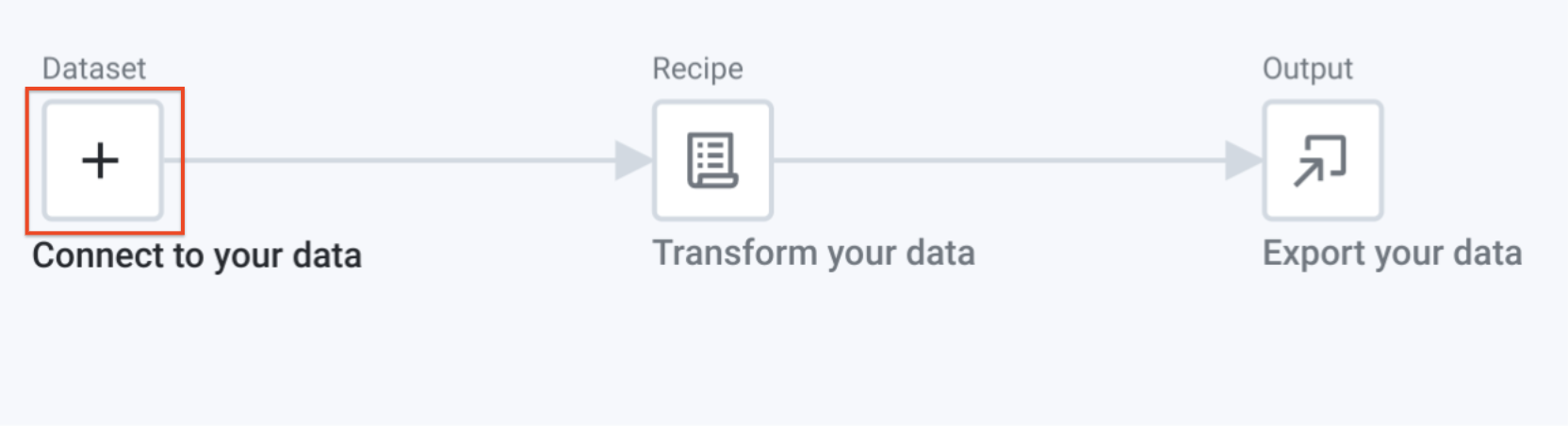

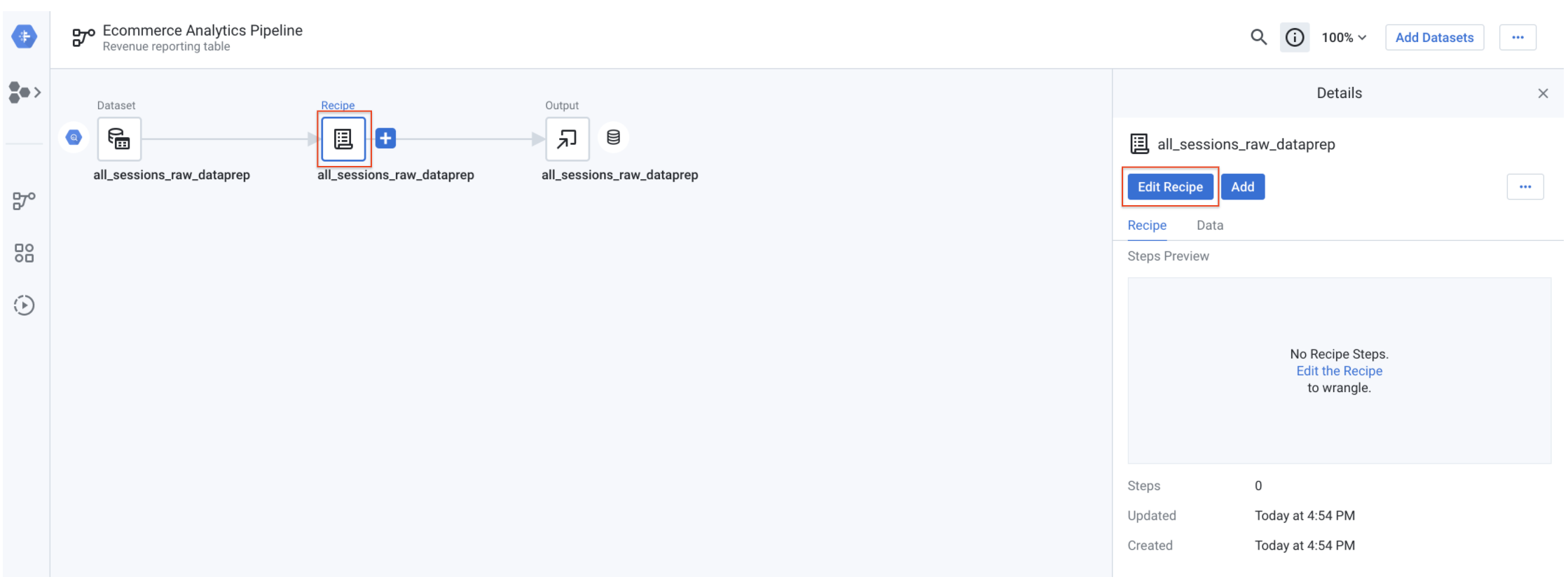

Dans cette tâche, vous allez connecter Cloud Dataprep à votre source de données BigQuery. Sur la page Cloud Dataprep :

-

Cliquez sur Create a flow (Créer un flux) en haut à droite.

-

Renommez le flux Untitled Flow (Flux sans titre) et indiquez les informations suivantes :

- Pour Flow Name (Nom du flux), saisissez

Ecommerce Analytics Pipeline(Pipeline d'analyse de données d'e-commerce). - Pour Flow Description (Description du flux), saisissez

Revenue reporting table(Table de rapport sur les revenus).

-

Cliquez sur OK.

-

Si le pop-up

What's a flow?(Qu'est-ce qu'un flux ?) s'affiche, cliquez sur Don't show me any helpers (N'afficher aucune aide). -

Dans la zone sous "Dataset" (Ensemble de données), cliquez sur l'icône Add (Ajouter).

-

Dans la boîte de dialogue Add Datasets to Flow (Ajouter des ensembles de données au flux), sélectionnez Import Datasets (Importer des ensembles de données).

-

Dans le volet de gauche, cliquez sur BigQuery.

-

Une fois votre ensemble de données ecommerce chargé, cliquez dessus.

-

Cliquez sur l'icône Create dataset (Créer un ensemble de données) (signe +) située à gauche de la table

all_sessions_raw_dataprep. -

Cliquez sur Import & Add to Flow (Importer et ajouter au flux) dans le coin inférieur droit.

La source de données est mise à jour automatiquement. Vous êtes prêt à passer à la tâche suivante.

Tâche 4 : Explorer les champs de données de l'ensemble "ecommerce" dans l'UI

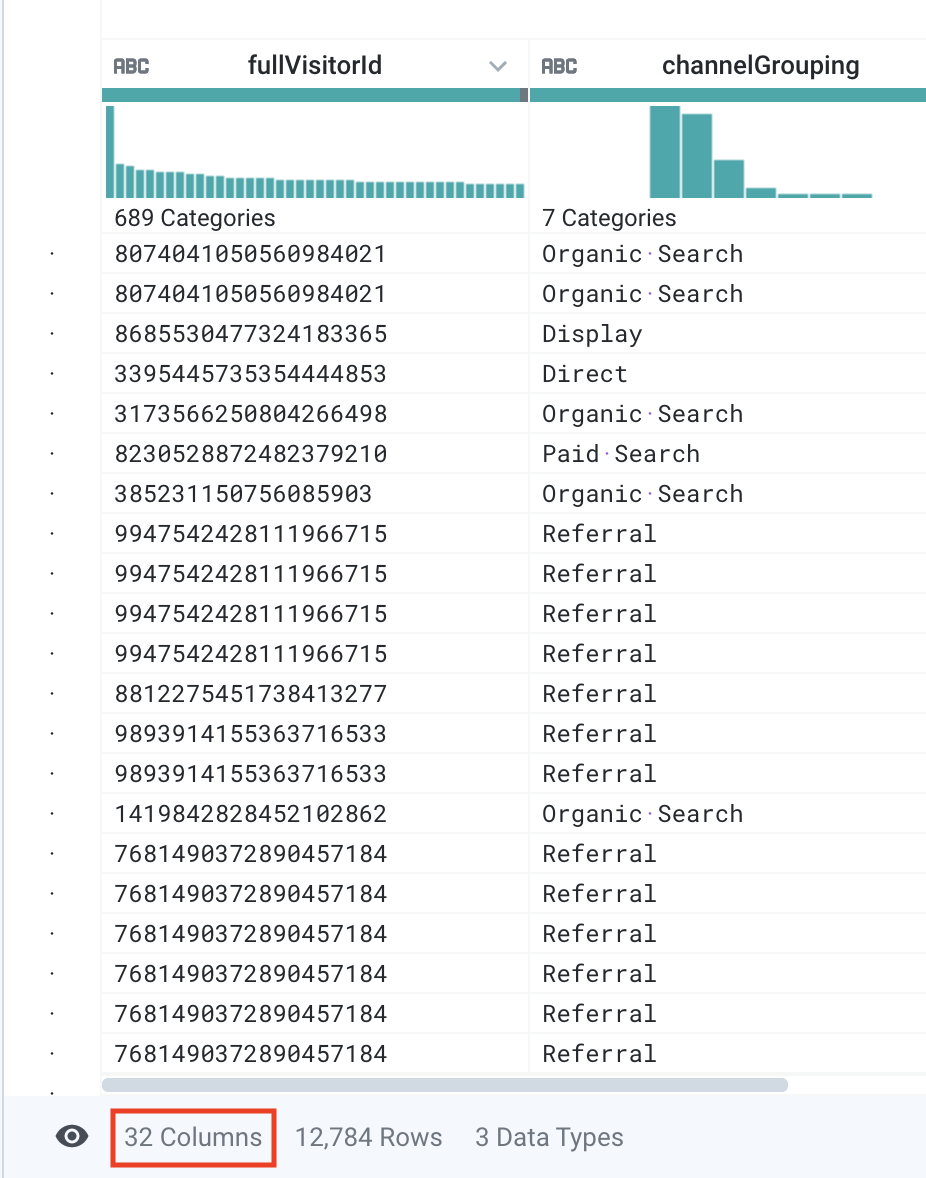

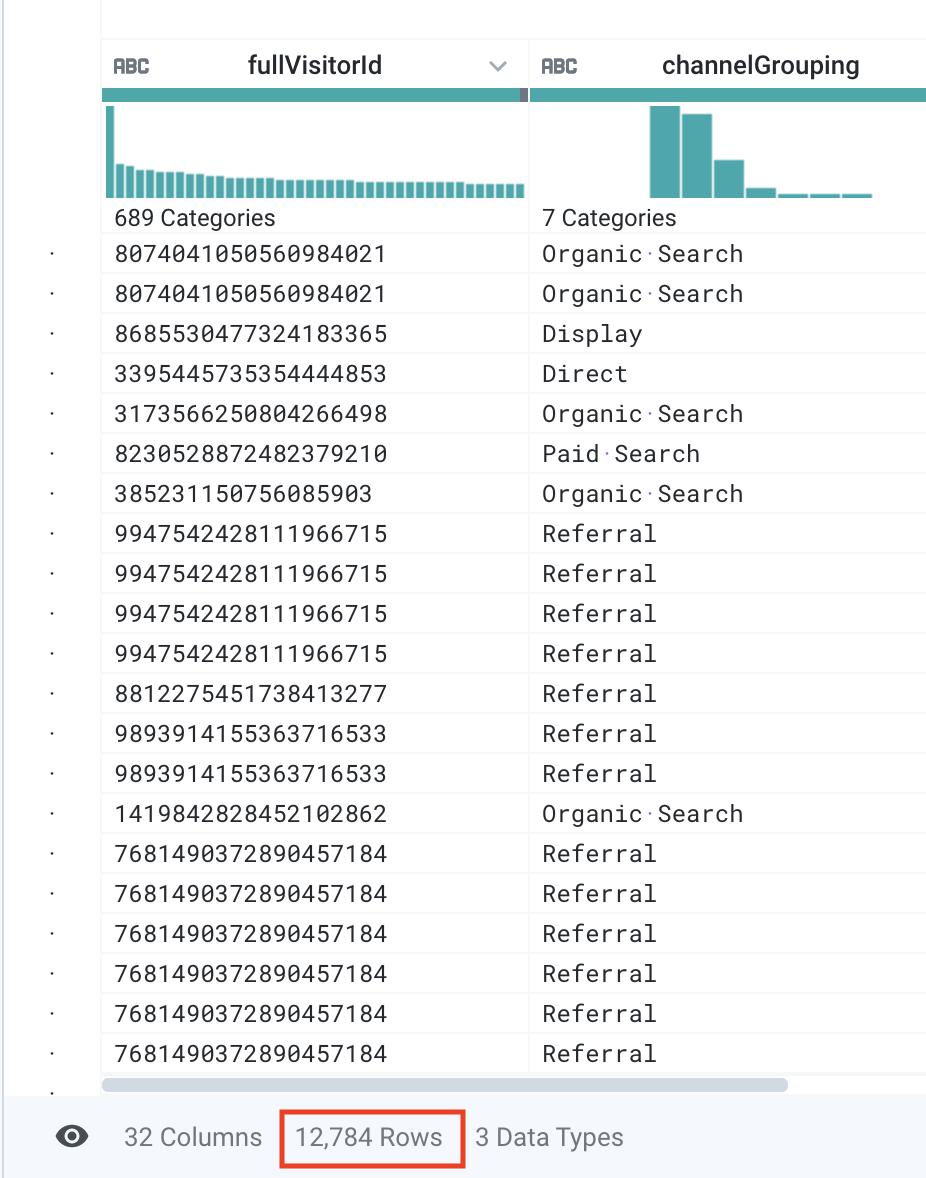

Dans cette tâche, vous allez charger et explorer un échantillon de l'ensemble de données dans Cloud Dataprep.

- Cliquez sur l'icône Recipe (Recette), puis sélectionnez Edit Recipe (Modifier la recette).

Cloud Dataprep charge un échantillon de votre ensemble de données dans la vue "Transformer" (Transformateur). Ce processus peut prendre quelques secondes. Vous êtes maintenant prêt à explorer les données.

Répondez aux questions suivantes :

- Combien de colonnes l'ensemble de données comprend-il ?

Réponse : 32 colonnes.

- Combien de lignes l'échantillon comprend-il ?

Réponse : Environ 12 000 lignes.

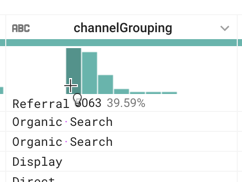

- Quelle est la valeur la plus commune dans la colonne

channelGrouping?

channelGrouping.

Réponse : "Referral" (Référence). Un site référent désigne généralement tout site Web contenant un lien vers votre contenu. Par exemple, un site Web différent a évalué un produit de notre site Web d'e-commerce et renvoie vers celui-ci. Dans ce cas, on parle d'un canal d'acquisition différent de celui des résultats des moteurs de recherche.

située en haut à droite, puis commencez à saisir le nom de la colonne dans la zone de texte Find column (Trouver une colonne). Ensuite, cliquez sur le nom de la colonne. La grille défile automatiquement pour faire apparaître la colonne concernée.

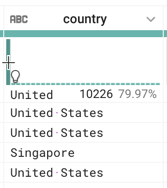

située en haut à droite, puis commencez à saisir le nom de la colonne dans la zone de texte Find column (Trouver une colonne). Ensuite, cliquez sur le nom de la colonne. La grille défile automatiquement pour faire apparaître la colonne concernée.- Les sessions sont créées depuis trois principaux pays. Lesquels ?

Réponse : États-Unis, Inde et Royaume-Uni

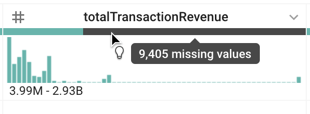

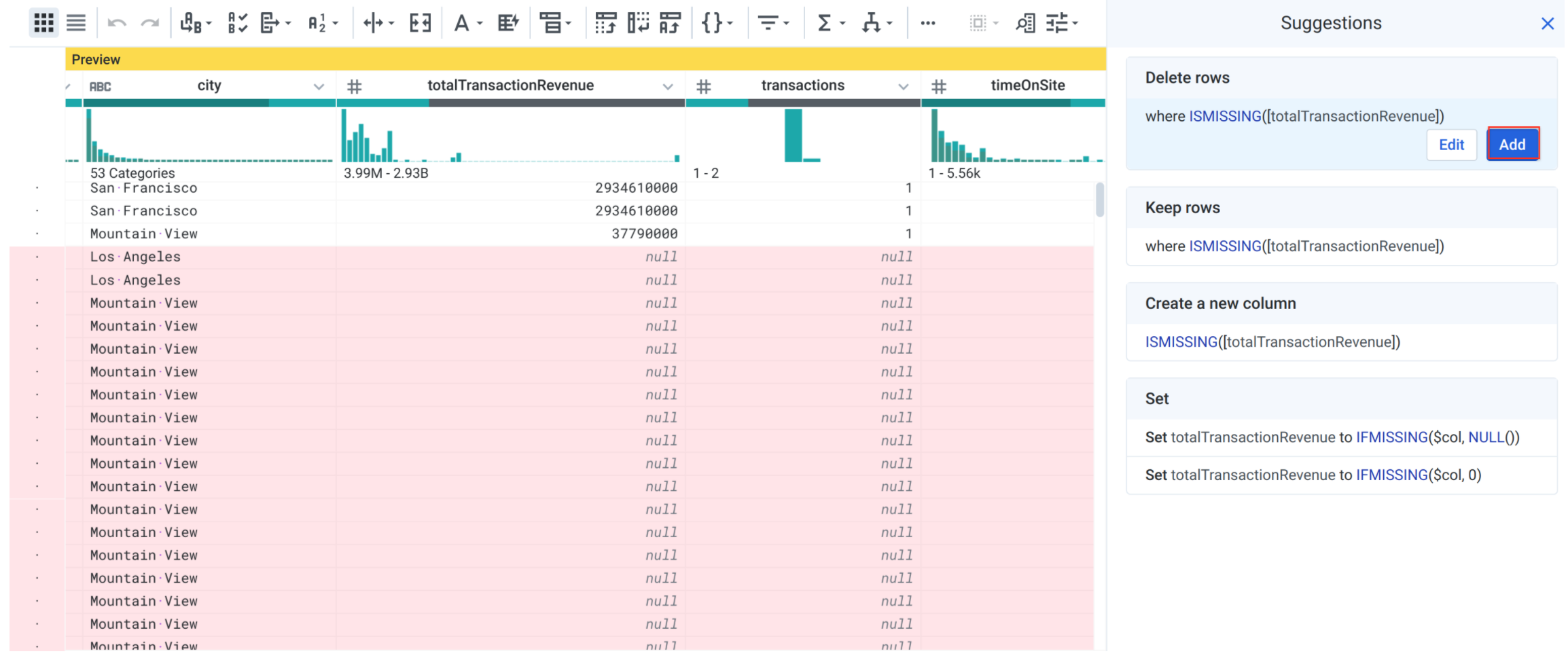

- Que représente la barre grise sous totalTransactionRevenue ?

Réponse : Les valeurs manquantes pour le champ totalTransactionRevenue. Cela signifie qu'un grand nombre de sessions de cet échantillon n'a pas généré de revenus. Plus tard, nous filtrerons ces valeurs afin que notre table finale ne contienne que les transactions des clients et les revenus associés.

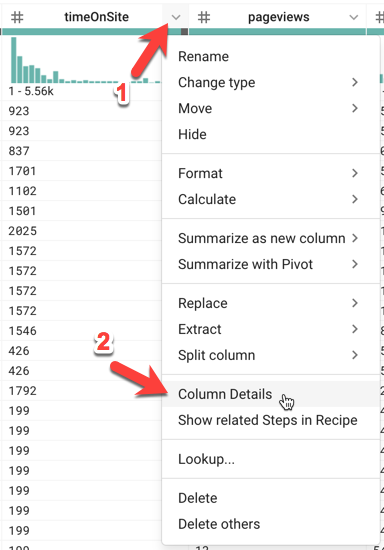

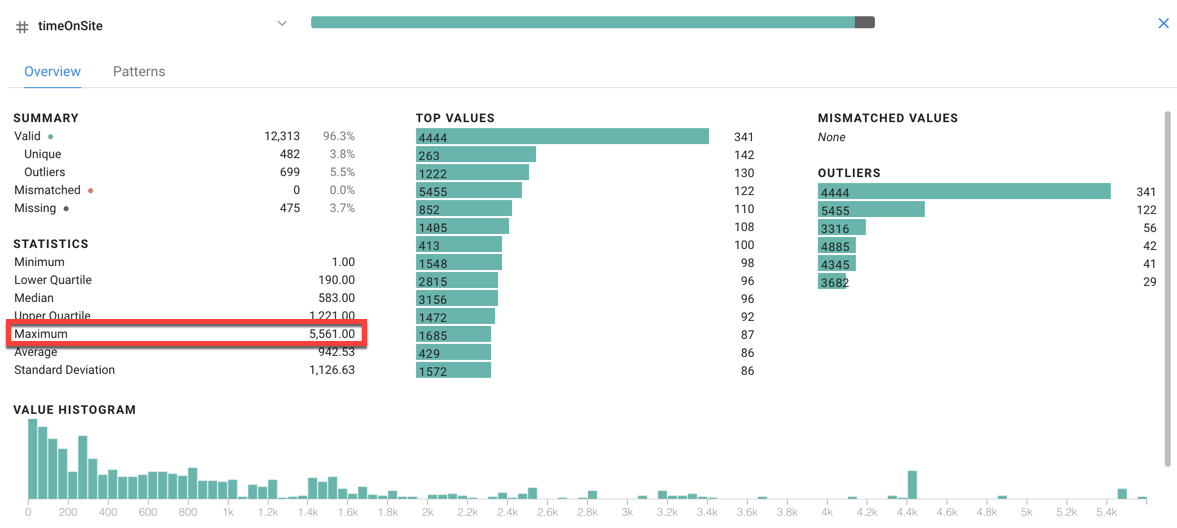

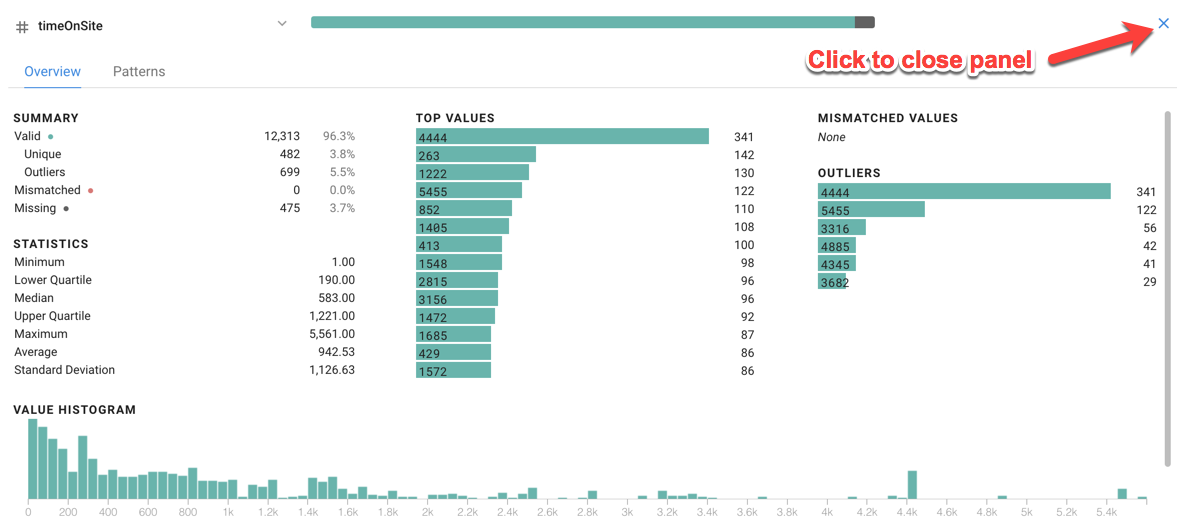

- Quels sont la valeur la plus élevée de

timeOnSiteen secondes, le nombre maximal depageviewset le nombre maximal desessionQualityDimpour l'échantillon de données ? Indice : Cliquez sur le menu Column Details (Détails de la colonne)pour ouvrir le menu situé à droite de la colonne

timeOnSite.

Pour fermer la fenêtre des détails, cliquez sur le bouton X Close Column Details (Fermer les détails de la colonne) situé en haut à droite. Répétez ensuite l'étape précédente pour afficher les détails des colonnes pageviews et sessionQualityDim.

Réponses :

- Maximum Time On Site (Temps maximal passé sur le site) : 5 561 secondes (ou 92 minutes)

- Maximum Pageviews (Nombre maximal de pages vues) : 155 pages

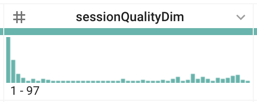

- Maximum Session Quality Dimension (Dimension qualitative maximale de la session) : 97

timeOnSite ne sont comptés qu'une seule fois par session. Nous explorerons l'unicité des données de visiteur et de session dans un prochain atelier.

- Si on considère l'histogramme

sessionQualityDim, les valeurs de données sont-elles réparties de manière uniforme ?

Réponse : Non, elles sont asymétriques (sessions de mauvaise qualité), comme prévu.

- Quelle est la plage de dates pour l'ensemble de données ? Indice : Examinez le champ date.

Réponse : 01/08/2017 (un jour de données)

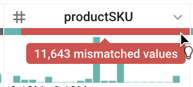

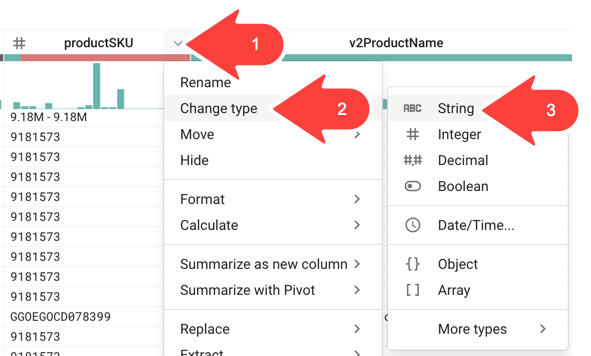

- Il est possible qu'une barre rouge s'affiche sous la colonne

productSKU. Si tel est le cas, qu'est-ce que cela signifie ?

Réponse : Une barre rouge indique des valeurs non concordantes. Pendant l'échantillonnage des données, Cloud Dataprep tente d'identifier automatiquement le type de chaque colonne. Si aucune barre rouge n'apparaît pour la colonne productSKU, cela signifie que Cloud Dataprep a réussi à identifier le type de colonne, c'est-à-dire le type String (Chaîne). Si une barre rouge s'affiche, cela signifie que Cloud Dataprep a repéré suffisamment de valeurs numériques lors de l'échantillonnage pour déterminer (de manière incorrecte) que le type de colonne devrait être Integer (Entier). Cloud Dataprep a également détecté des valeurs non entières et a donc marqué ces valeurs comme incompatibles. En réalité, productSKU ne correspond pas toujours à un entier (par exemple, "GGOEGOCD078399" peut être une valeur correcte). Dans ce cas, Cloud Dataprep a donc identifié de manière incorrecte le type de colonne, qui devrait être une chaîne et non un entier. Vous corrigerez cela plus tard dans l'atelier.

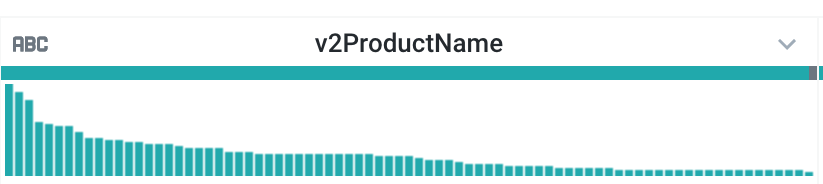

- Si on considère la colonne

v2ProductName, quels sont les produits les plus populaires ?

Réponse : Les produits Nest

- Si on considère la colonne

v2ProductCategory, quelles sont les catégories de produits les plus populaires ?

Réponses :

Les catégories de produits les plus populaires sont les suivantes :

-

Nest

-

Bags

-

(not set) (non défini) (ce qui signifie que certaines sessions ne sont associées à aucune catégorie)

-

Vrai ou faux ? La variante

productVariantla plus courante estCOLOR.

Réponse : Faux. Il s'agit de (not set) (non défini), car aucune variante n'est disponible pour la plupart des produits (plus de 80 %).

- Quelles sont les deux valeurs de la colonne type ?

Réponse : PAGE et EVENT (ÉVÉNEMENT).

Un utilisateur peut générer de nombreux types d'interactions lorsqu'il navigue sur votre site Web. On peut par exemple citer l'enregistrement de données de session lorsqu'il consulte une PAGE ou un EVENT (Événement) spécial (comme "clicking on a product" [cliquer sur un produit]). Plusieurs types de résultats peuvent être déclenchés exactement au même moment. Vous filtrerez donc souvent les résultats par type pour éviter de les comptabiliser deux fois. Nous en reparlerons ultérieurement, lors d'un atelier d'analyse.

- Quel est le nombre maximal de

productQuantity?

Réponse : 100 (votre réponse peut varier)

productQuantity indique le nombre d'unités du produit qui ont été ajoutées au panier. "100" signifie que 100 unités d'un seul produit ont été ajoutées.

- Quel est le principal

currencyCodepour les transactions ?

Réponse : USD (dollar américain)

- Existe-t-il des valeurs valides pour

itemQuantityouitemRevenue?

Réponse : Non, toutes les valeurs sont NULL (ou manquantes).

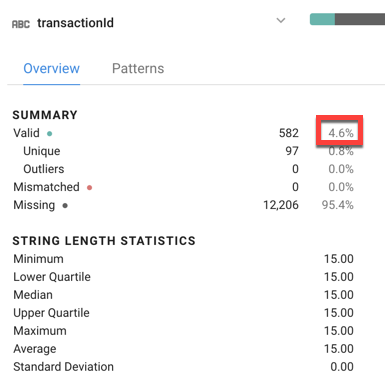

- Quel pourcentage de valeurs

transactionIdest valide ? À quoi est-ce que cela correspond pour notre ensemble de donnéesecommerce?

- Réponse : Environ 4,6 % des ID de transaction sont valides, ce qui correspond au taux de conversion moyen du site Web (4,6 % des visiteurs effectuent au moins une transaction).

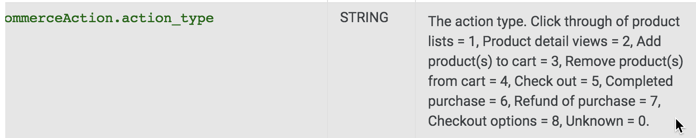

- Combien existe-t-il de valeurs

eCommerceAction_typeet quelle est la valeur la plus courante ?

Réponses : Il y a sept valeurs dans notre échantillon. La valeur la plus courante est zéro (0), ce qui indique que le type est inconnu. Ce constat est logique dans la mesure où la majorité des sessions sur notre site Web n'aboutissent à aucune transaction, car les utilisateurs ne font que consulter le contenu du site.

- Selon le schéma, à quoi correspond

eCommerceAction_type = 6?

eCommerceAction et lisez la description du mappage.

Réponse : 6 correspond à "Completed purchase" (Achat effectué). Plus tard dans cet atelier, nous ingérerons cette mise en correspondance dans notre pipeline de données.

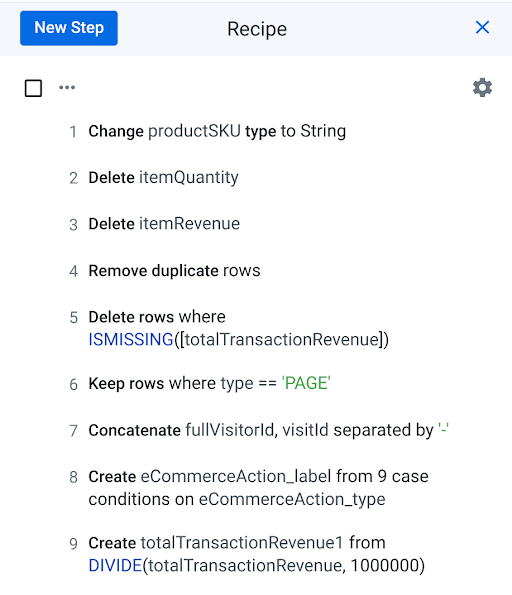

Tâche 5 : Nettoyer les données

Dans cette tâche, vous allez nettoyer les données en supprimant les colonnes inutilisées, en éliminant les doublons, en créant des champs calculés et en filtrant les lignes non souhaitées.

Convertir le type de données de la colonne productSKU

- Pour vous assurer que le type de la colonne productSKU est String (Chaîne), cliquez sur

pour ouvrir le menu situé à droite de la colonne productSKU, puis sélectionnez Change type > String (Changer de type > Chaîne).

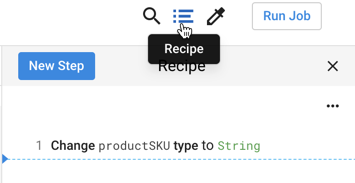

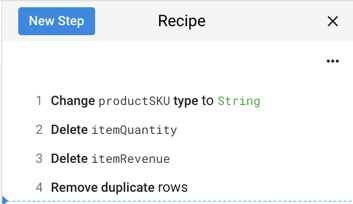

- Vérifiez que la première étape de votre pipeline de transformation de données a été créée en cliquant sur l'icône Recipe (Recette) :

Supprimer les colonnes inutilisées

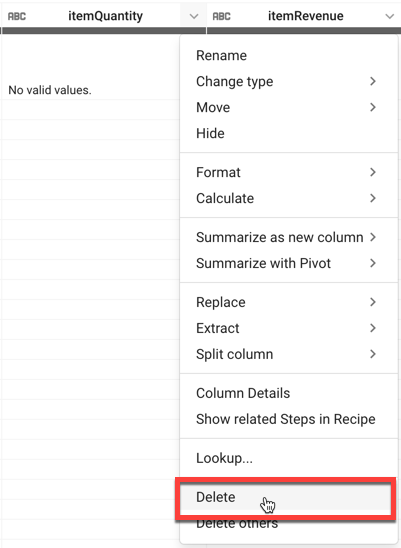

Comme nous l'avons mentionné précédemment, nous allons supprimer les colonnes itemQuantity et itemRevenue, car elles ne contiennent que des valeurs NULL, sans intérêt dans cet atelier.

- Ouvrez le menu de la colonne itemQuantity, puis cliquez sur Delete (Supprimer).

- Procédez de la même manière pour supprimer la colonne itemRevenue.

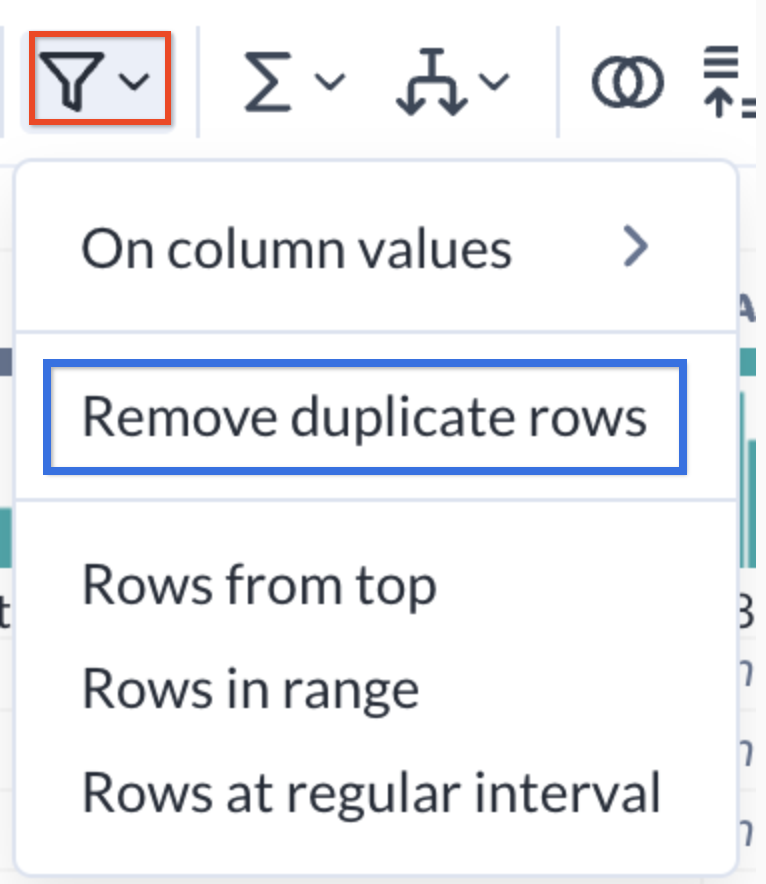

Dédupliquer les lignes

Votre équipe vous a informé que l'ensemble de données source pouvait contenir des doublons. Supprimons-les grâce à une étape de déduplication.

- Cliquez sur l'icône Filter rows (Filtrer les lignes) dans la barre d'outils, puis sur Remove duplicate rows (Supprimer les lignes en double).

-

Cliquez sur Add (Ajouter) dans le panneau de droite.

-

Passez en revue la recette que vous avez créée jusqu'à présent. Elle doit ressembler à ceci :

Filtrer les sessions sans revenus

Votre équipe vous a demandé de créer une table de toutes les sessions d'utilisateurs ayant acheté au moins un article sur votre site Web. Filtrez les sessions utilisateur avec un revenu NULL.

- Sous la colonne totalTransactionRevenue, cliquez sur la barre grise Missing values (Valeurs manquantes). Toutes les lignes avec une valeur manquante pour totalTransactionRevenue sont maintenant mises en surbrillance en rouge.

- Dans le panneau Suggestions, dans Delete rows (Supprimer les lignes), cliquez sur Add (Ajouter).

Cette étape filtre votre ensemble de données afin de n'inclure que les transactions générant des revenus (où totalTransactionRevenue n'est pas NULL).

Filtrer les sessions en fonction des vues de PAGE

L'ensemble de données contient des sessions de différents types, par exemple PAGE (pour les pages vues) ou EVENT (ÉVÉNEMENT) (pour des événements déclenchés, tels que "viewed product categories" [catégories de produits visualisées] ou "added to cart" [ajouté au panier]). Pour éviter de comptabiliser deux fois les pages vues de la session, ajoutez un filtre afin de n'inclure que les résultats liés à une vue de page.

-

Dans l'histogramme situé sous la colonne type, cliquez sur la barre PAGE. Toutes les lignes de type PAGE sont maintenant mises en surbrillance en vert.

-

Dans le panneau Suggestions, dans Keep rows (Conserver les lignes), cliquez sur Add (Ajouter).

Tâche 6 : Enrichir les données

Dans la documentation sur le schéma, consultez la description de visitId pour déterminer si cette valeur est propre à toutes les sessions utilisateur ou juste à l'utilisateur.

-

visitId: identifiant de cette session. Il fait partie de la valeur généralement stockée sous forme de cookieutmb. Il est propre à cet utilisateur. Pour obtenir un identifiant parfaitement unique, vous devez combiner les valeurs des champs fullVisitorId et visitId.

Comme vous pouvez le voir, visitId n'est pas unique pour tous les utilisateurs. Nous devrons créer un identifiant unique.

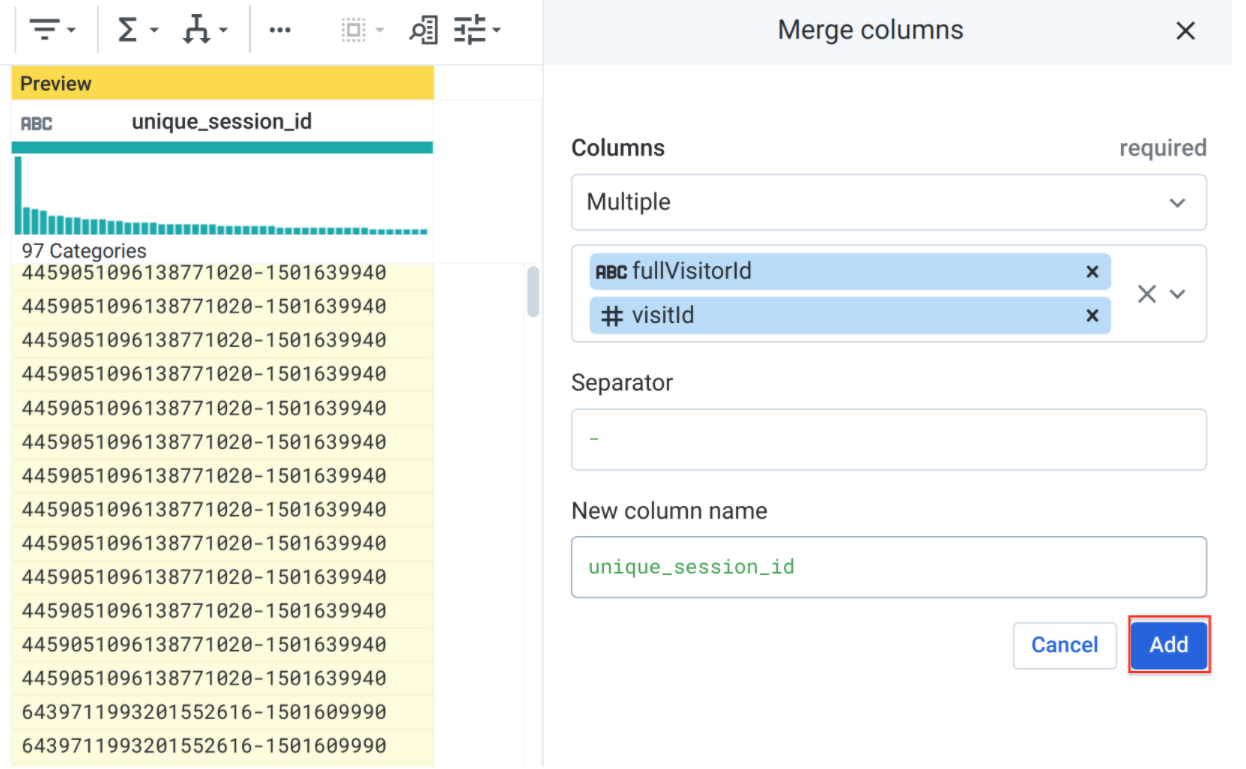

Créer une colonne pour un identifiant de session unique

Comme vous l'avez découvert, l'ensemble de données ne comprend pas de colonne pour les sessions de visiteur unique. Créez un identifiant unique pour chaque session en concaténant les champs fullVisitorId et visitId.

- Cliquez sur l'icône Merge columns (Fusionner les colonnes) de la barre d'outils.

-

Dans le champ Columns (Colonnes), sélectionnez

fullVisitorIdetvisitId. -

Dans le champ Separator (Séparateur), saisissez un trait d'union :

-. -

Dans le champ New column name (Nom de la nouvelle colonne), saisissez

unique_session_id.

- Cliquez sur Add (Ajouter).

La colonne unique_session_id est maintenant une combinaison de fullVisitorId et visitId. Dans un prochain atelier, nous étudierons si chaque ligne de cet ensemble de données se situe au niveau de la session unique (une ligne par session utilisateur) ou à un niveau encore plus granulaire.

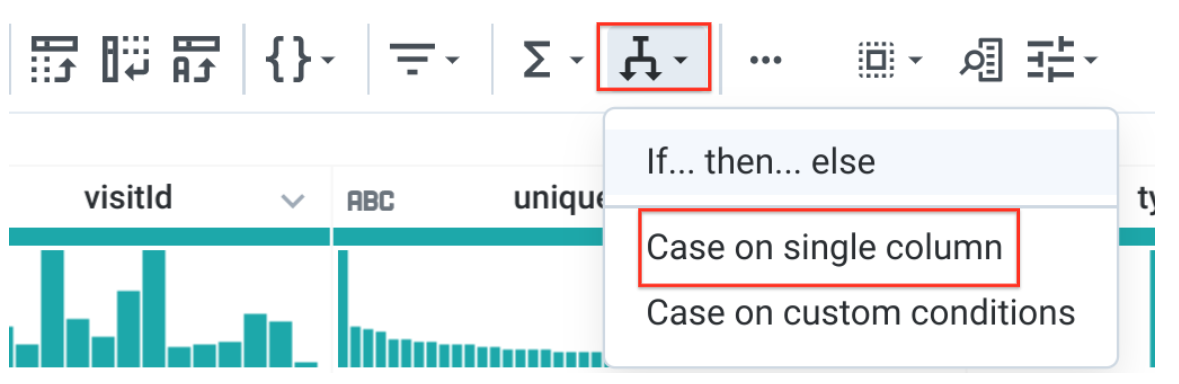

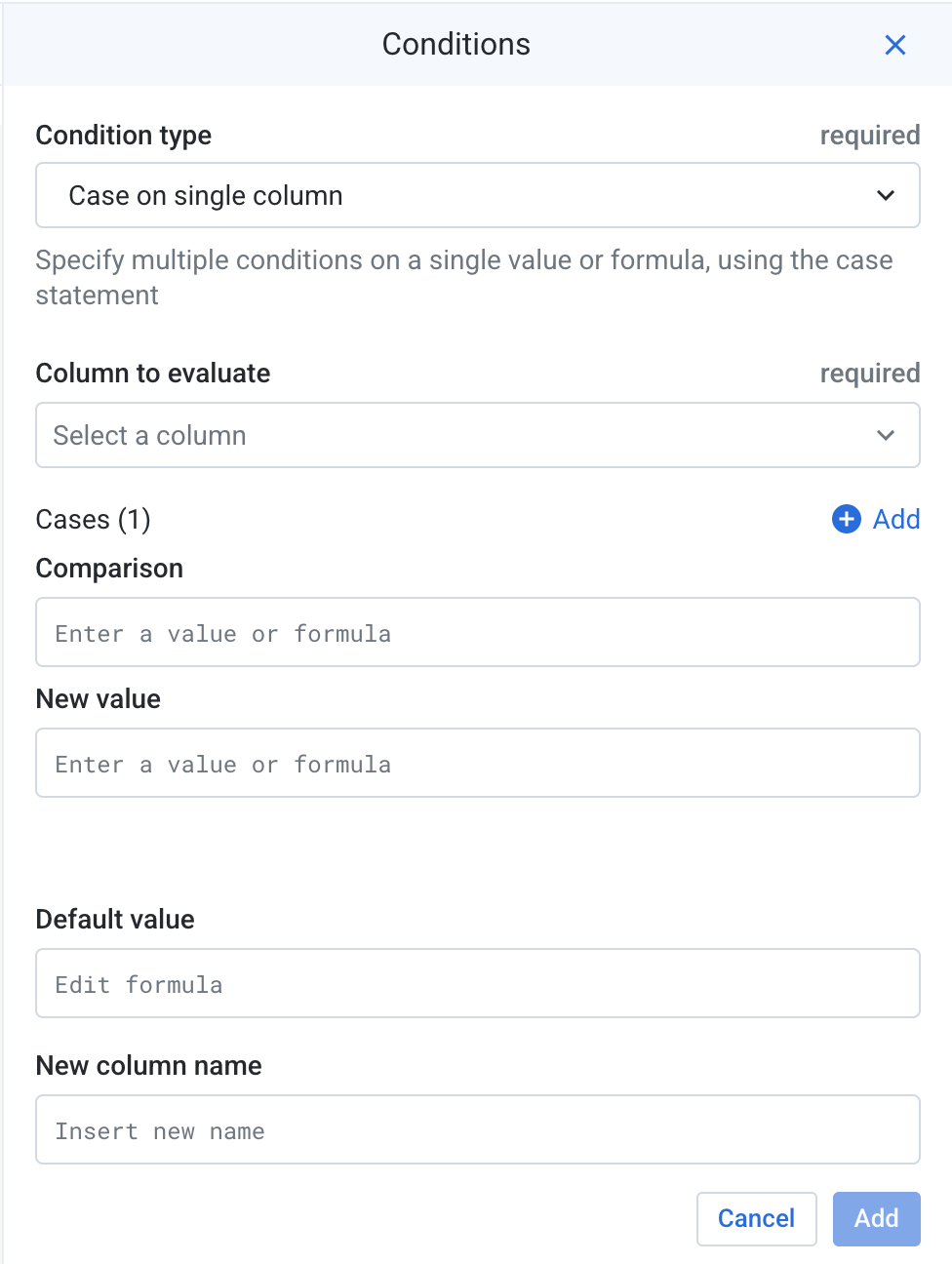

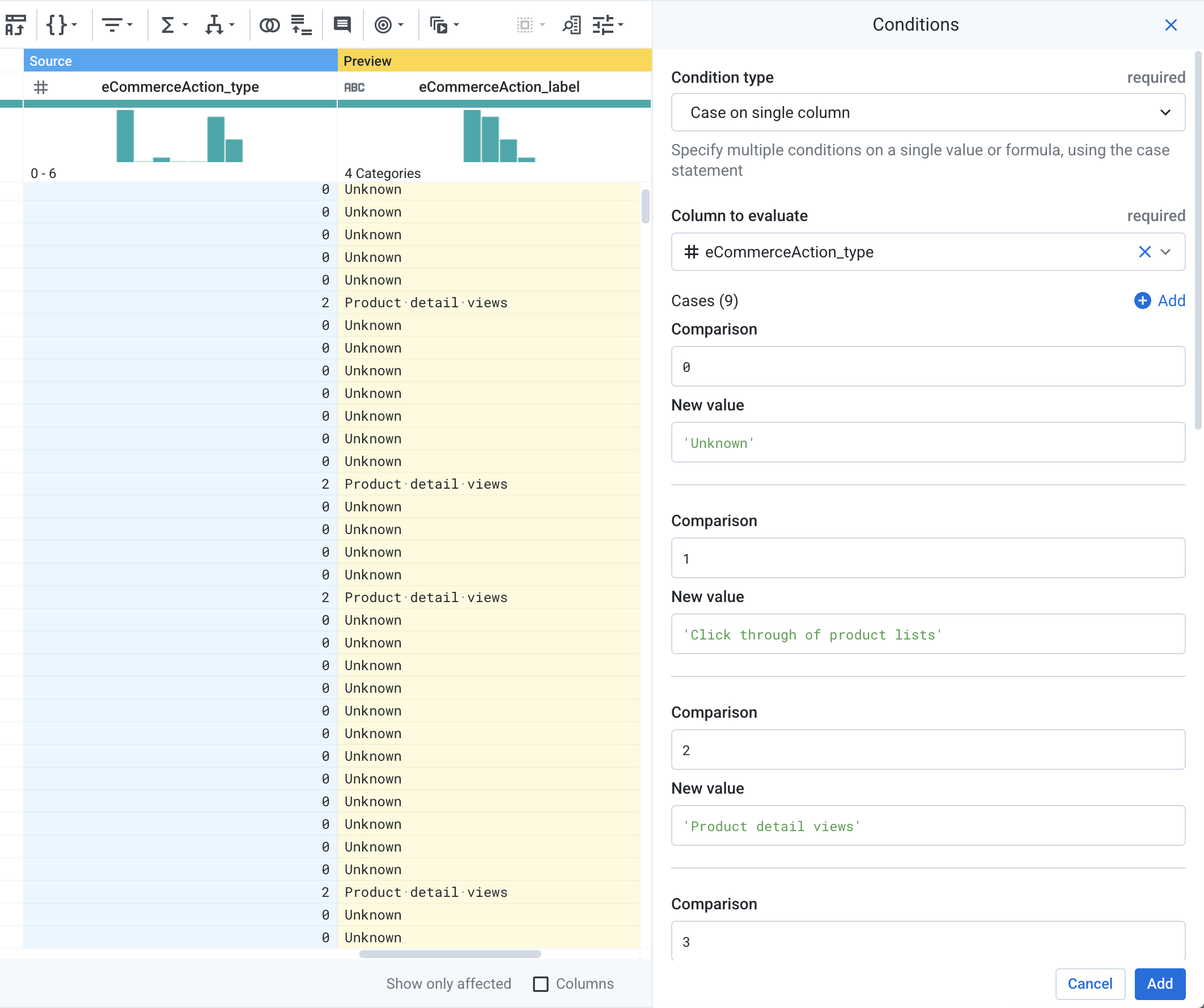

Créer une instruction de cas pour le type d'action d'e-commerce

Comme vous l'avez vu précédemment, les valeurs de la colonne eCommerceAction_type sont des entiers correspondant aux actions d'e-commerce effectuées dans cette session. Par exemple, 3 = "Add to Cart" (Ajouter au panier) ou 5 = "Check out" (Paiement). Cette mise en correspondance n'est pas évidente pour nos utilisateurs finaux. Créons donc un champ calculé qui ajoute le nom de la valeur.

- Cliquez sur Conditions dans la barre d'outils, puis sur Case on single column (Cas sur une seule colonne).

-

Pour Column to evaluate (Colonne à évaluer), indiquez

eCommerceAction_type. -

À côté de Cases (1) (Cas [1]), cliquez sur Add (Ajouter) huit fois pour un total de neuf cas.

- Pour chaque cas, indiquez les valeurs de mise en correspondance suivantes (en incluant les apostrophes) :

|

Comparaison |

Nouvelle valeur |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

-

Dans le champ New column name (Nom de la nouvelle colonne), saisissez

eCommerceAction_label. Conservez les valeurs par défaut des autres champs. -

Cliquez sur Add (Ajouter).

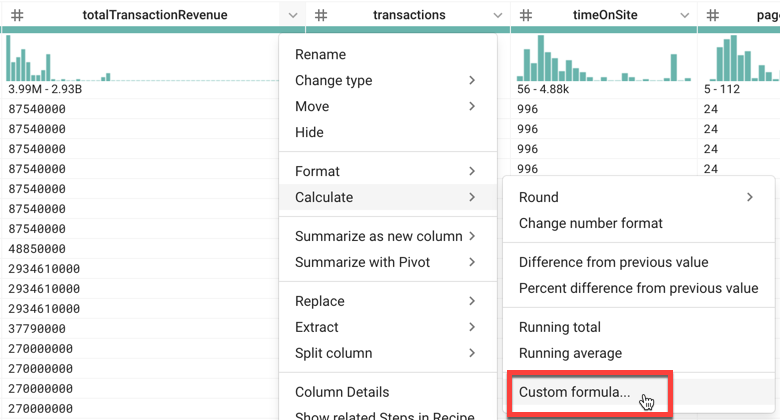

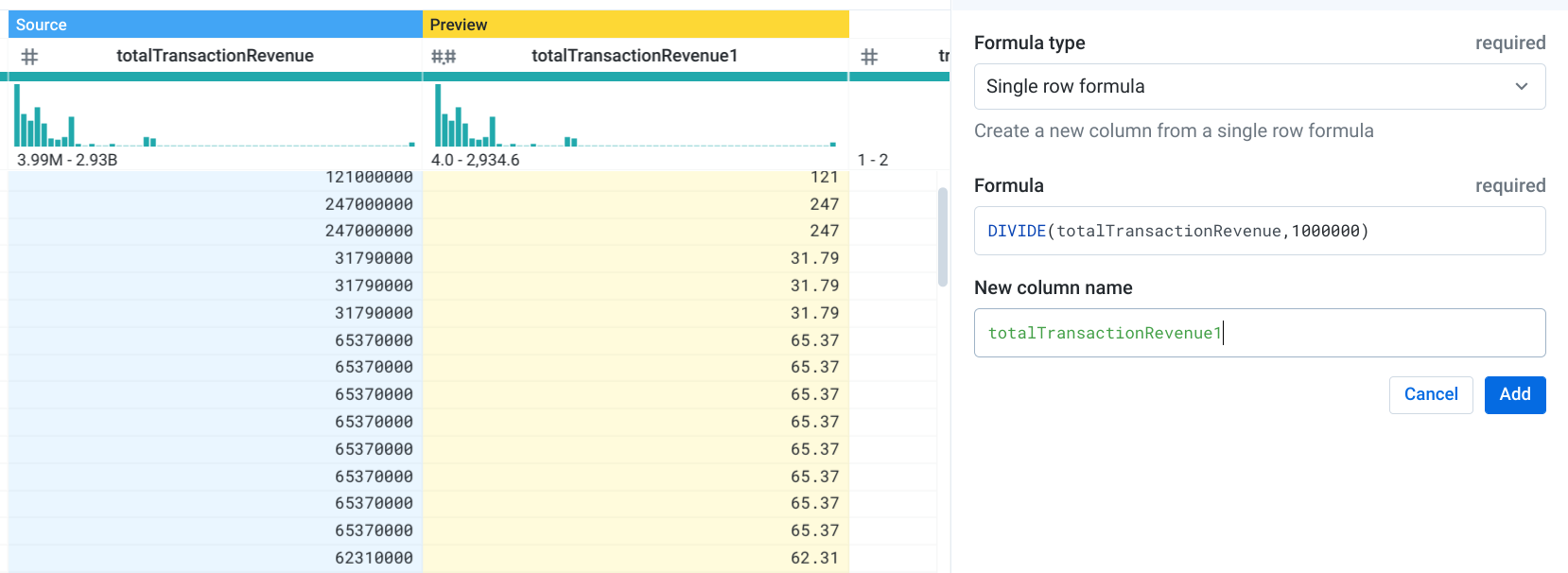

Ajuster les valeurs de la colonne totalTransactionRevenue

Comme indiqué dans le schéma, la colonne totalTransactionRevenue contient des valeurs transmises à Analytics multipliées par 10^6 (par ex., 2,40 sera noté 2400000). Divisez maintenant le contenu de cette colonne par 10^6 pour obtenir les valeurs d'origine.

- Cliquez sur

pour ouvrir le menu situé à droite de la colonne totalTransactionRevenue, puis sélectionnez Calculate > Custom formula (Calculer > Formule personnalisée).

- Pour Formula (Formule), saisissez

DIVIDE(totalTransactionRevenue,1000000), et pour New column name (Nom de la nouvelle colonne), saisisseztotalTransactionRevenue1. Un aperçu de la transformation est affiché :

- Cliquez sur Add (Ajouter).

totalTransactionRevenue1. Cliquez sur  pour ouvrir le menu situé à droite de la colonne

pour ouvrir le menu situé à droite de la colonne totalTransactionRevenue1, puis sélectionnez Change type > Decimal (Changer de type > Décimal).- Passez en revue la liste complète des étapes de votre recette :

- Cliquez sur Run (Exécuter).

Tâche 7 : Exécuter des jobs Cloud Dataprep dans BigQuery

-

Sur la page Run Job (Exécuter le job), sélectionnez Dataflow + BigQuery comme Running Environment (Environnement d'exécution).

-

Sous Publishing Actions (Actions de publication), cliquez sur Edit (Modifier) à droite de Create-CSV.

-

Sur la page suivante, sélectionnez BigQuery dans le menu de gauche.

-

Sélectionnez votre ensemble de données ecommerce.

-

Cliquez sur Create a New Table (Créer une table) dans le panneau à droite.

-

Nommez votre table revenue_reporting.

-

Sélectionnez Drop the Table every run (Supprimer la table à chaque exécution).

-

Cliquez sur Update (Mettre à jour).

-

Cliquez sur EXÉCUTER.

Une fois votre job Cloud Dataprep exécuté, actualisez votre page BigQuery et vérifiez que la table de sortie revenue_reporting existe.

Cliquez sur Vérifier ma progression pour valider l'objectif.

Félicitations !

Vous avez exploré votre ensemble de données "ecommerce" et créé un pipeline de transformation de données avec Cloud Dataprep.

Terminer votre quête

Cet atelier d'auto-formation fait partie de la quête Data Engineering. Une quête est une série d'ateliers associés qui constituent un parcours de formation. Si vous terminez cette quête, vous obtenez un badge attestant de votre réussite. Vous pouvez rendre publics les badges que vous recevez et ajouter leur lien dans votre CV en ligne ou sur vos comptes de réseaux sociaux. Inscrivez-vous à cette quête pour obtenir immédiatement les crédits associés. Découvrez toutes les quêtes disponibles dans le catalogue Google Cloud Skills Boost.

Atelier suivant

Continuez votre quête en suivant l'atelier Traitement ETL sur Google Cloud avec Dataflow et BigQuery ou consultez ces suggestions :

Étapes suivantes et informations supplémentaires

-

Alteryx sur Google Cloud Marketplace

-

Vous possédez un compte Google Analytics et souhaitez interroger vos propres ensembles de données BigQuery ? Suivez ce guide d'exportation.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 20 septembre 2023

Dernier test de l'atelier : 20 septembre 2023

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.