Points de contrôle

Create a Dataproc cluster

/ 50

Submit a job

/ 30

Update a cluster

/ 20

Dataproc : Qwik Start – Console

GSP103

Présentation

Dataproc est un service cloud rapide, facile à utiliser et entièrement géré permettant d'exécuter de manière plus simple et plus rentable les clusters Apache Spark et Apache Hadoop. Les opérations qui prenaient auparavant des heures ou des jours sont maintenant l'affaire de quelques minutes ou secondes. Créez rapidement des clusters Dataproc, puis redimensionnez-les à tout moment afin que vos pipelines de données ne saturent pas vos clusters.

Cet atelier vous montre comment utiliser la console Google Cloud pour créer un cluster Dataproc, exécuter un job Apache Spark simple dans le cluster, puis modifier le nombre de nœuds de calcul dans le cluster.

Objectifs de l'atelier

Dans cet atelier, vous allez apprendre à :

- créer un cluster Dataproc dans la console Google Cloud ;

- exécuter un job Apache Spark simple ;

- modifier le nombre de nœuds de calcul dans le cluster.

Préparation

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement. Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google. L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte. -

Si nécessaire, copiez le nom d'utilisateur inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue Se connecter. Cliquez sur Suivant.

-

Copiez le mot de passe inclus dans le panneau Détails concernant l'atelier et collez-le dans la boîte de dialogue de bienvenue. Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis dans le panneau de gauche. Ne saisissez pas vos identifiants Google Cloud Skills Boost. Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés. -

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas aux essais offerts.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Vérifier que l'API Cloud Dataproc est activée

Pour que vous puissiez créer un cluster Dataproc dans Google Cloud, l'API Cloud Dataproc doit être activée. Pour le vérifier :

-

Cliquez sur le menu de navigation > API et services > Bibliothèque :

-

Saisissez Cloud Dataproc dans la boîte de dialogue Rechercher des API et des services. La console affiche l'API Cloud Dataproc dans les résultats de la recherche.

-

Cliquez sur API Cloud Dataproc pour connaître l'état de l'API. Si elle n'est pas déjà activée, cliquez sur le bouton Activer.

Une fois l'API activée, suivez les instructions de l'atelier.

Attribuer l'autorisation au compte de service

Pour attribuer l'autorisation de stockage au compte de service, qui est requise pour créer un cluster :

-

Accédez au menu de navigation > IAM et administration > IAM.

-

Cliquez sur l'icône en forme de crayon correspondant au compte de service

compute@developer.gserviceaccount.com. -

Cliquez sur le bouton + AJOUTER UN AUTRE RÔLE, puis sélectionnez Administrateur Storage.

Une fois que vous avez sélectionné le rôle Administrateur Storage, cliquez sur Enregistrer.

Tâche 1 : Créer un cluster

-

Dans la console Cloud Platform, sélectionnez le menu de navigation > Dataproc > Clusters, puis cliquez sur Créer un cluster.

-

Cliquez sur Créer pour Cluster sur Compute Engine.

-

Configurez les champs suivants pour votre cluster et acceptez les valeurs par défaut pour tous les autres champs :

| Champ | Valeur |

|---|---|

| Nom | example-cluster |

| Région | |

| Zone | |

| Série de machines | E2 |

| Type de machine | e2-standard-2 |

| Nombre de nœuds de calcul | 2 |

| Taille du disque principal | 30 Go |

| Adresse IP interne uniquement | Désélectionnez "Configurer toutes les instances pour qu'elles ne possèdent que des adresses IP internes". |

us-central1 ou europe-west1, pour isoler les ressources (y compris les instances de VM et Cloud Storage) et les zones de stockage de métadonnées utilisées par Cloud Dataproc dans la région spécifiée par l'utilisateur.

- Cliquez sur Créer pour créer le cluster.

Votre nouveau cluster figure ensuite dans la liste des clusters. Sa création peut prendre quelques minutes. Son état indique Provisionnement jusqu'à ce qu'il soit prêt à être utilisé, puis passe à Exécution.

Tester la tâche terminée

Cliquez sur Vérifier ma progression pour valider la tâche exécutée.

Tâche 2 : Envoyer un job

Pour exécuter un exemple de job Spark :

-

Cliquez sur Jobs dans le volet de gauche pour passer à l'affichage des jobs de Dataproc, puis cliquez sur Envoyer un job.

-

Définissez les champs suivants pour mettre le job à jour. Acceptez les valeurs par défaut pour tous les autres champs :

| Champ | Valeur |

|---|---|

| Région | |

| Cluster | example-cluster |

| Type de job | Spark |

| Classe principale ou fichier JAR | org.apache.spark.examples.SparkPi |

| Fichiers JAR | file:///usr/lib/spark/examples/jars/spark-examples.jar |

| Arguments | 1000 (définit le nombre de jobs) |

- Cliquez sur Envoyer.

Votre job doit apparaître dans la liste Jobs, qui affiche les jobs de votre projet avec son cluster, son type et son état actuel. L'état du job indique Exécution, puis Réussi une fois l'opération terminée.

Tester la tâche terminée

Cliquez sur Vérifier ma progression pour valider la tâche exécutée.

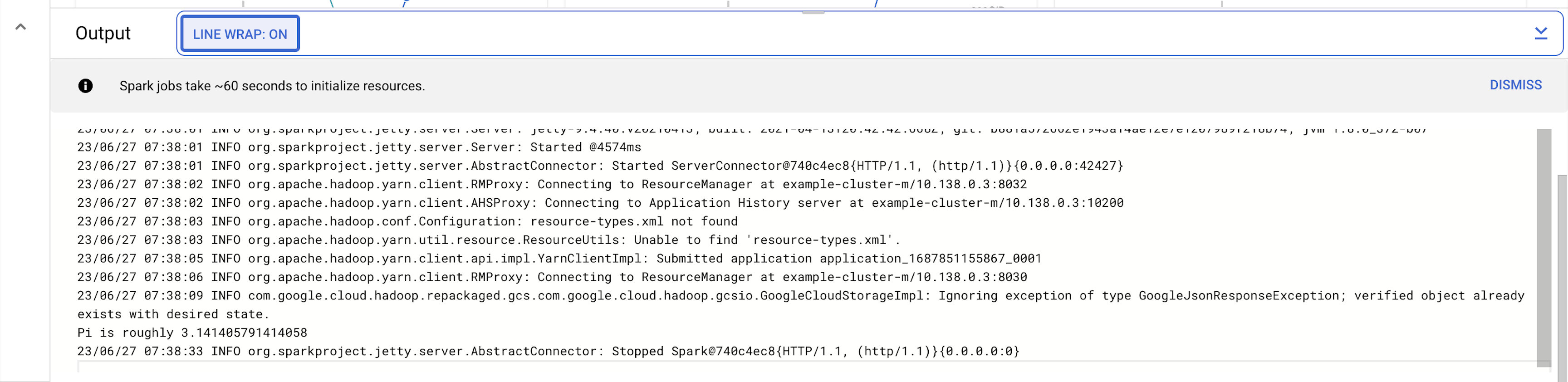

Tâche 3 : Afficher le résultat du job

Pour voir le résultat du job terminé, procédez comme suit :

-

Cliquez sur l'ID du job dans la liste Jobs.

-

Sélectionnez Retour à la ligne : activé

ou faites défiler la page vers la droite pour afficher la valeur calculée de pi. Le résultat avec Retour à la ligne : activéressemble en principe à ce qui suit :

Votre job est parvenu à calculer une valeur approximative de pi !

Tâche 4 : Mettre à jour un cluster pour modifier le nombre de nœuds de calcul

Pour modifier le nombre d'instances de nœuds de calcul dans votre cluster :

-

Sélectionnez Clusters dans le volet de navigation de gauche pour revenir à la vue des clusters Dataproc.

-

Cliquez sur example-cluster dans la liste Clusters. Par défaut, la page présente un aperçu de l'utilisation du processeur de votre cluster.

-

Cliquez sur Configuration pour afficher les paramètres actuels de votre cluster.

-

Cliquez sur Modifier. Vous pouvez maintenant modifier le nombre de nœuds de calcul.

-

Saisissez 4 dans le champ Nœuds de calcul.

-

Cliquez sur Enregistrer.

Votre cluster est maintenant mis à jour. Vérifiez le nombre d'instances de VM dans le cluster.

Tester la tâche terminée

Cliquez sur Vérifier ma progression pour valider la tâche exécutée.

-

Pour réexécuter le job une fois le cluster mis à jour, cliquez sur Jobs dans le volet de gauche, puis sur ENVOYER UN JOB.

-

Définissez les mêmes champs que ceux configurés à la section Envoyer un job :

| Champ | Valeur |

|---|---|

| Région | |

| Cluster | example-cluster |

| Type de job | Spark |

| Classe principale ou fichier JAR | org.apache.spark.examples.SparkPi |

| Fichiers JAR | file:///usr/lib/spark/examples/jars/spark-examples.jar |

| Arguments | 1000 (définit le nombre de jobs) |

- Cliquez sur Envoyer.

Tâche 5 : Tester vos connaissances

Voici quelques questions à choix multiples qui vous permettront de mieux maîtriser les concepts abordés lors de cet atelier. Répondez-y du mieux que vous le pouvez.

Félicitations !

Vous savez désormais créer et mettre à jour un cluster Dataproc, puis envoyer un job dans ce cluster, à l'aide de la console Google Cloud.

Étapes suivantes et informations supplémentaires

Cet atelier fait partie d'une série appelée "Qwik Starts". Les ateliers de cette série sont conçus pour vous présenter brièvement les nombreuses fonctionnalités proposées par Google Cloud. Pour suivre un autre atelier, recherchez "Qwik Starts" dans le catalogue.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 21 mars 2024

Dernier test de l'atelier : 21 mars 2024

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.